Cara, não foi nada super complexo, ele só, por muito mérito dele, conhecia muito bem a estrutura da google.

Já vi outros pesquisadores foda que nem ele conseguir um impacto igual a ele só por manjar muito daquela empresa. Inspiração demais esses caras que vão a fundo no contexto, nas tecnologias, na regra de negócio

https://x.com/omer_asfu/status/2018370967571943455?s=46

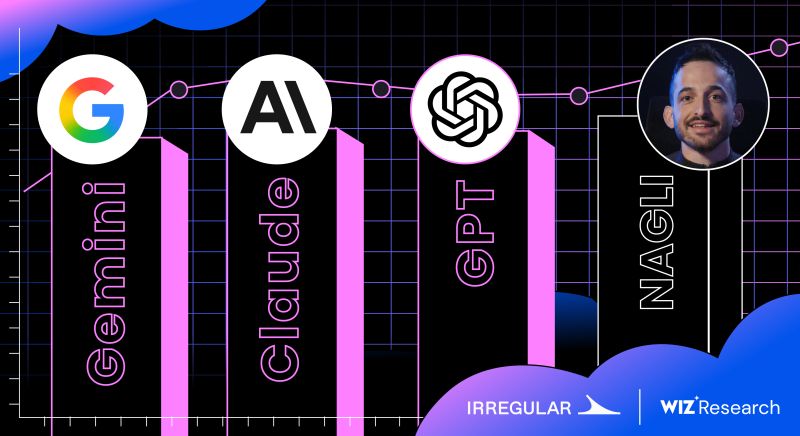

Por 1 relatório não fico em 3º, quem sabe no próximo Quarter =)

Tive uma ótima experiência com o time de triagem, sem nenhum problema na reprodução dos itens de bypasses encontrados em fixings feitos, bem como a elevação da criticidade quando contestei em primeiro momento. E os bountys são bem generosos.

Link do ranking: https://www.microsoft.com/en-us/msrc/blog/2026/01/congratulations-to-the-top-msrc-2025-q4-security-researchers

Eu não costumo divulgar essas coisas, inclusive faz mais de 1 mês que tenho essa info, mas também precisamos celebrar pequenas conquistas.

Caramba que reflexão foda e vai muito de encontro com o que publiquei uma vez sobre engenharia social não ser vista como hacking de verdade etc (eu ainda tenho um pouco desse preconceito), por mais que critico isso nos meus artigos:

https://x.com/moltbook/status/2017177460203479206?s=46

Moltbook: https://www.moltbook.com/u

https://lab.ctbb.show/research/parse-and-parse-mime-validation-bypass-to-xss-via-parser-differential

Saiu faz pouco

No caso essa minha querie é negativa, eu tenho um banco de dados aqui com 1.2Milhoes de Urls, sendo que no minimo 700 mil é de lugares que nenhuma ferramenta que existe atualmente, pelo menos pública, pega.

Como eu sei disso? Pq eu que criei a ferramenta que faz scraping constante nesse site que eu uso como insumo de URLs novas. Ele não tem a funcionalidade de só baixar todas urls pra x endereço, eu preciso monitorar novas URLs toda hora (inclusive aquelas que não são do meu programa em questão).

E é aqui que geralmente tu começa a ter resultados diferentes. Se tu roda as mesmas ferramentas, vai nos mesmos programas, procura as mesmas falhas, confia nos mesmo resultados... adivinha? Duplicado.

Comentário random:

Cara, ta comecando na área, estudou umas paradas e tá com dúvida, quer me perguntar se já tentei x coisa etc

Pode sempre me mandar uma mensagem no DM, tô sempre aberto pra ajudar vocês ae com o que eu puder.

As vezes eu demoro pra responder, a vida é correria, os melhores amigos tão ligados já como é mas a gente sempre dá um jeito

Cara, ta comecando na área, estudou umas paradas e tá com dúvida, quer me perguntar se já tentei x coisa etc

Pode sempre me mandar uma mensagem no DM, tô sempre aberto pra ajudar vocês ae com o que eu puder.

As vezes eu demoro pra responder, a vida é correria, os melhores amigos tão ligados já como é mas a gente sempre dá um jeito

Depois dessa nerdiada infinita, e que é um assunto que eu não domino, principalmente pela necessidade de se saber C, vamos de podcast novo que tá estreando no youtube agora:

https://www.youtube.com/watch?v=yJo0QERKYMs

https://www.youtube.com/watch?v=yJo0QERKYMs